还在为边缘端的大模型运行发愁?

还在为算力不够、模型太大束手无策?

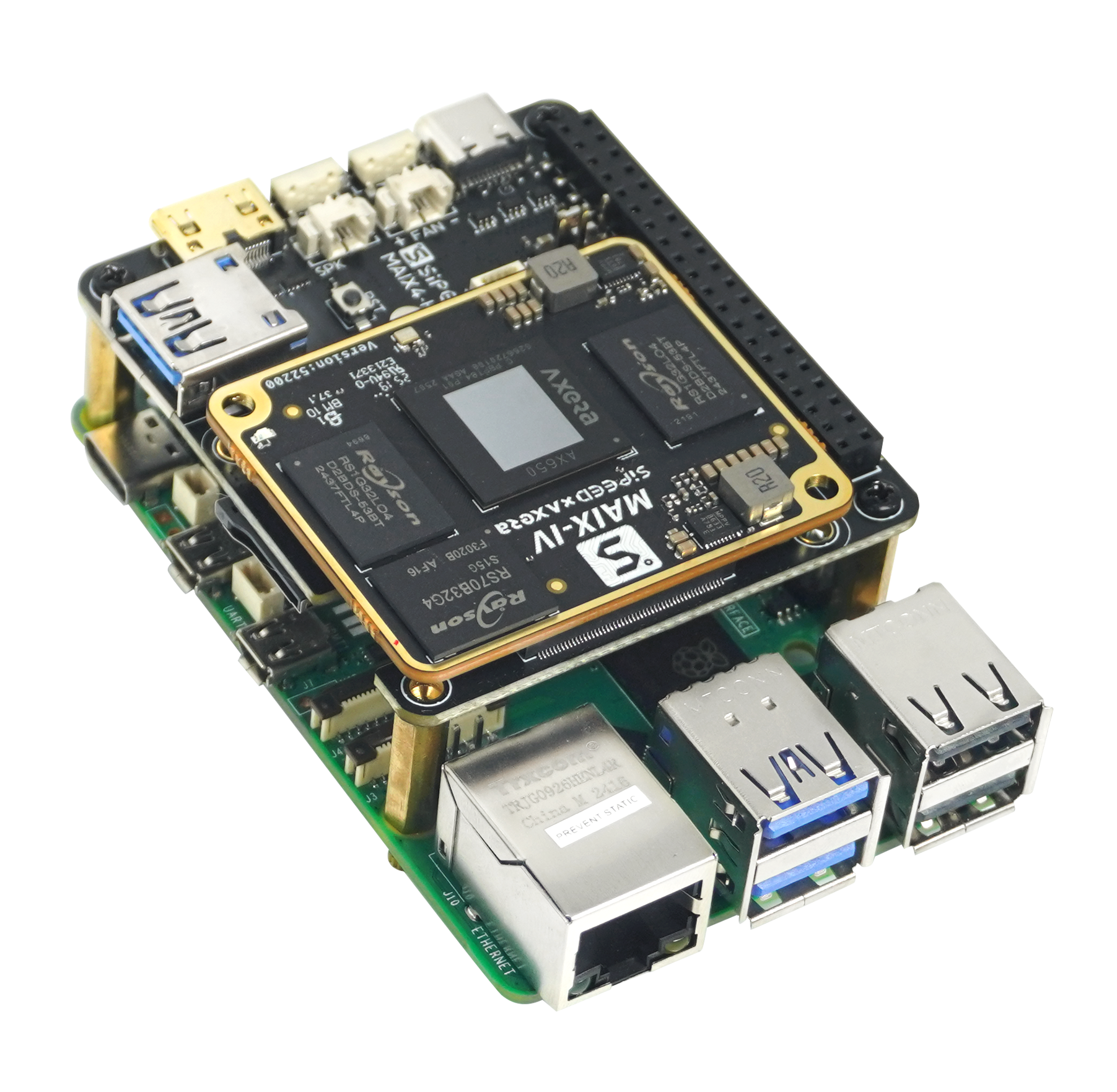

Maix4-HAT 搭载爱芯元智第三代 AX650 芯片,支持一板两用,不仅是你树莓派5 的 PCIe AI HAT 的算法加速模块,更是一个可以独立运行 LLM模型的微型 AI 模组,目前套餐首发价格低至999元!

NPU 算力高达 72TOPS @ INT4 / 18TOPS @ INT8配备 64bit LPDDR4X 高速内存,最高 8GB RAM 模块

尺寸仅 56mm x 65mm,便于嵌入各种终端设备

支持主流多模态大模型本地加速部署

LLM支持:Qwen-3、DeepSeek-R1-Distill

先进视觉模型:YOLO-World、DepthAnything v2

语音模型:Whisper、MeloTTS

多模态模型:InternVL3-1B、SD v1.5

支持「一板两用」,开发方式灵活

树莓派 AI 加速 HAT

专为树莓派5设计,完美适配 PCIe 接口

即插即用,被识别为独立 NPU 协处理器

支持通过 axcl 库直接调用 NPU 进行模型推理

独立运行的端侧大模型开发板

离线运行 LLM,无需依赖云端

可作为简易 AI 开发平台使用

体积小巧,适配嵌入式智能终端设备

应用场景实例

智能家居

YOLO-World 实时物品识别

DeepSeekR1/Qwen3 语音交互

本地ASR+LLM+TTS 智能助理

工业应用

DepthAnythingv2 实现深度测量动图

支持 32 路 1080P 视频分析

教育/科研/创客项目

开箱即用Ubuntu

系统丰富的wiki及详细文档

热门大模型持续更新

是高校科研/AI 教育平台的理想硬件载体