1. Yolo11简介

YOLO11 系列是 YOLO 家族中最先进的 (SOTA)、最轻量级、最高效的模型,其表现优于其前辈。它由 Ultralytics 创建,该组织发布了 YOLOv8,这是迄今为止最稳定、使用最广泛的 YOLO 变体。YOLO11 将延续 YOLO 系列的传奇。

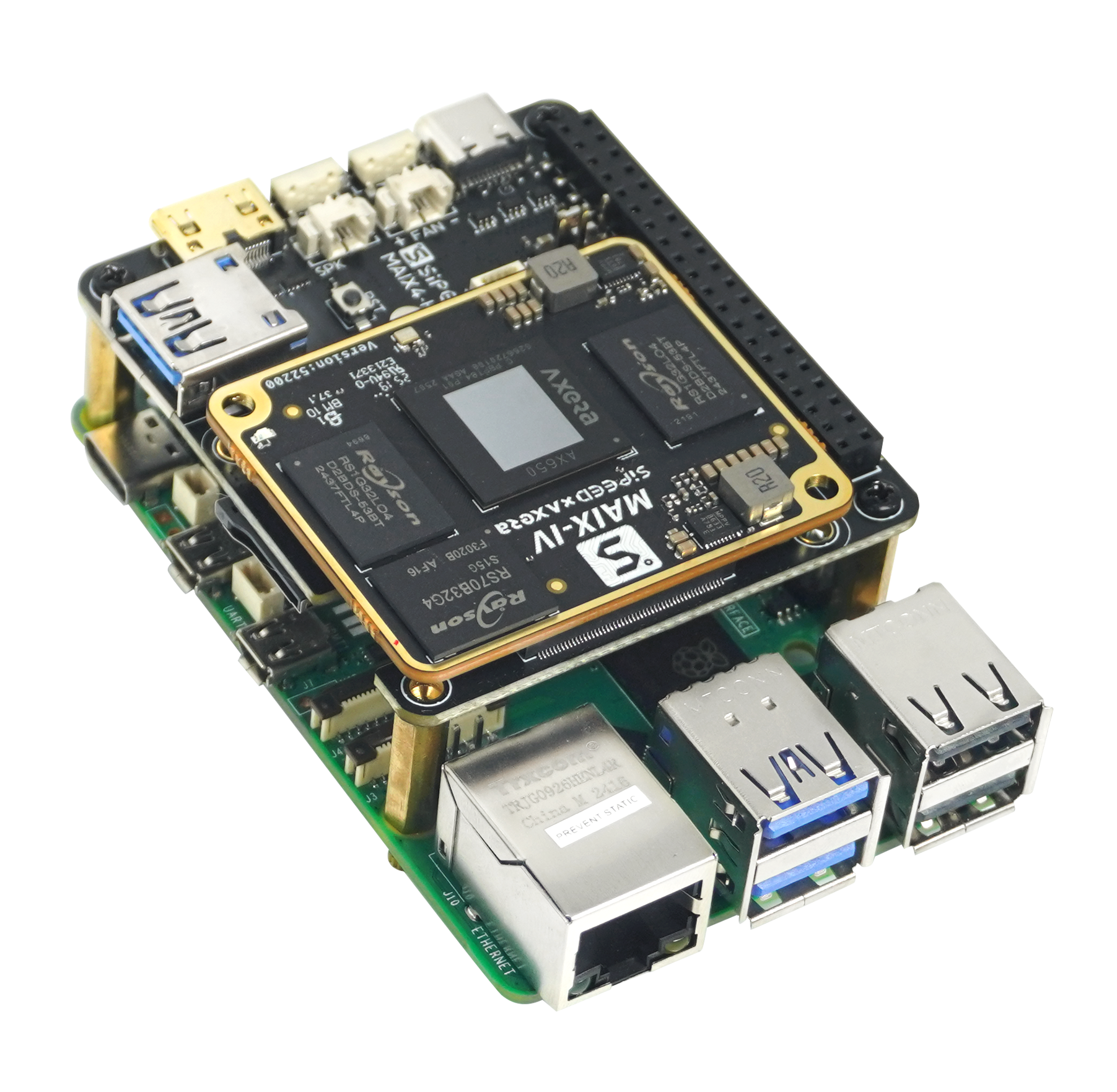

本教程针对目标检测算法yolo11的训练和部署到EASY-EAI-Orin-nano(RK3576)进行说明,而数据标注方法可以参考我们往期的文章。

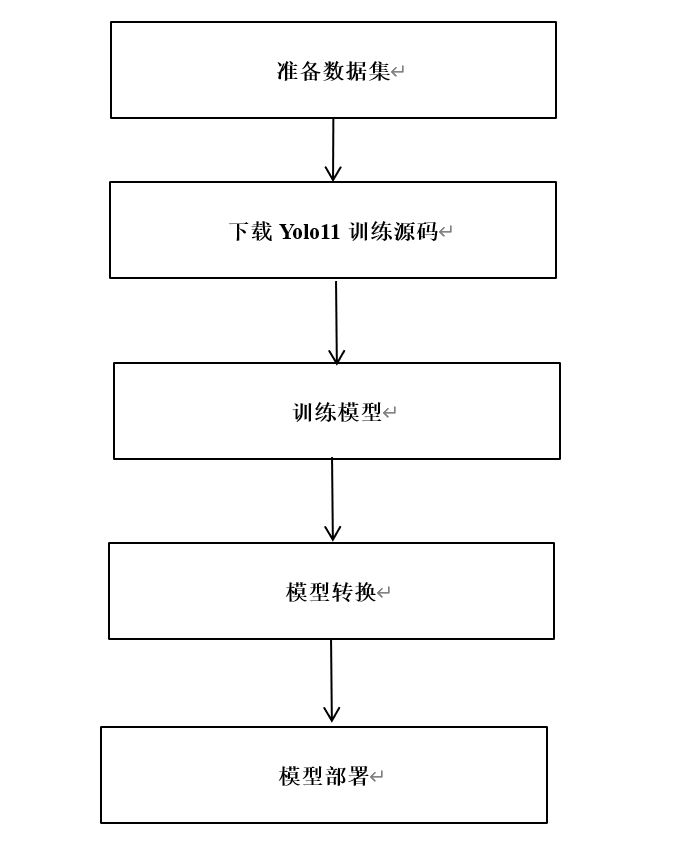

2. Yolo11模型训练

Yolov11训练代码在导出部分对比原版会有一些修改,建议下载我们的训练代码。百度网盘链接:

https://pan.baidu.com/s/1yLKZkCOVmfUlbnWbpl103A?pwd=1234

提取码: 1234。

2.1 数据集准备

在开始yolo11训练前,先准备好待训练数据,如VOC2007,下载链接:

http://host.robots.ox.ac.uk/pascal/VOC/voc2007/index.html

然后将VOC2007数据分成训练集和测试集两个目录,如下图示意:

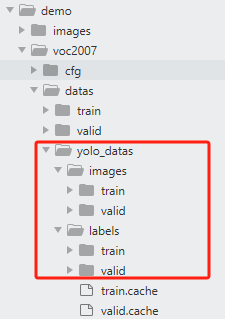

2.2 Voc转Yolo

数据准备好后,使用data/voc_2_yolo.py脚本将Voc数据格式转成Yolo数据格式。转换完成后的数据存储在原数据同级目录的yolo_data下,如下图示意:

2.3 训练参数配置

数据转换完成后,在配置模型的训练参数:data.yaml,default.yaml,yolo11.yaml.

其中:

data.yaml:为待训练数据和验证数据的路径,以及类别数和类别名称;

default.yaml:为yolo11训练参数,可自行调整模型训练的参数;

Yolo11.yaml:为yolo11模型结构,在模型训练时,你需要修改类别数。

更多关于yolo11信息可参考:

https://blog.csdn.net/qq_45972324/article/details/143892222

2.4 模型训练

完成上述步骤后,就可以开始训练模型了,打开train.py脚本,输入data.yaml,default.yaml,yolo11.yaml路径,如下代码段所示:

fromultralyticsimportYOLOimportos

os.environ["KMP_DUPLICATE_LIB_OK"] ="TRUE" # 程序报OMP: Hint This means...错误时使用

if__name__ =='__main__': cfg ="./demo/voc2007/cfg/default.yaml" data ='./demo/voc2007/cfg/data.yaml' weight ="./demo/voc2007/cfg/yolo11.yaml" # pt 或 yolovx.yaml model = YOLO(weight)

results = model.train( data=data, cfg=cfg )

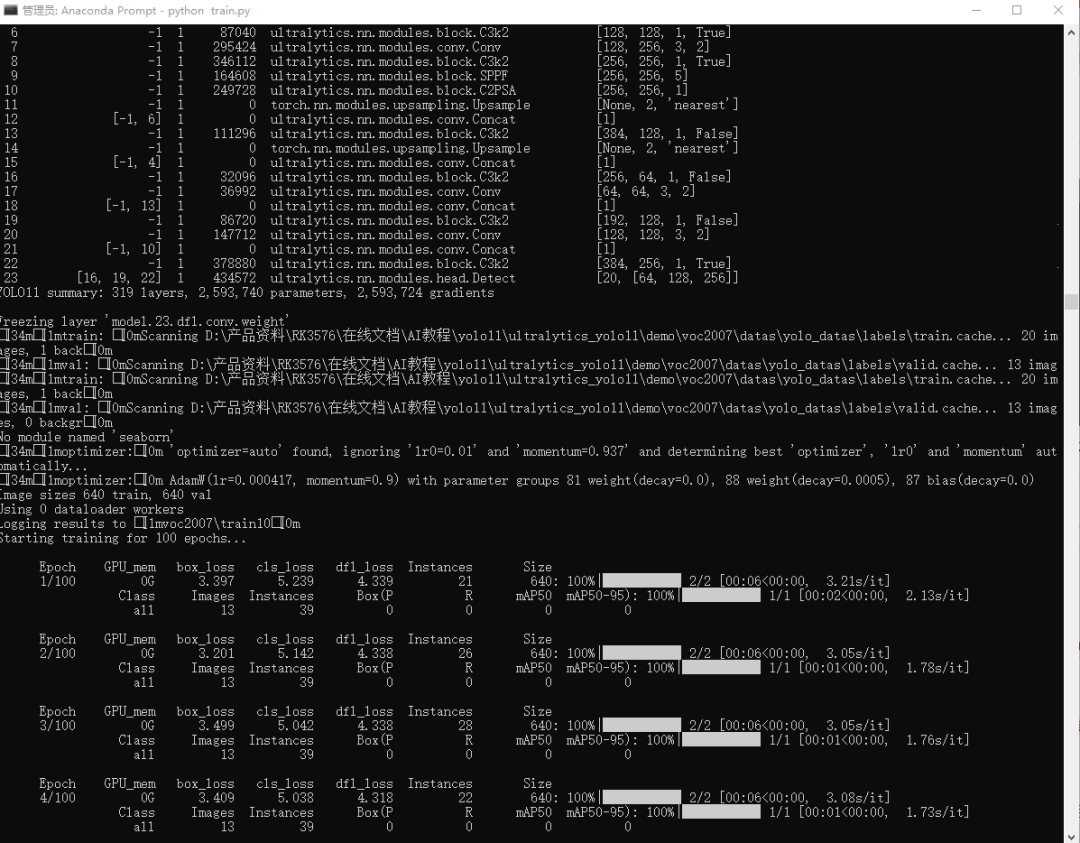

执行train.py训练脚本,开始模型训练,如下示意图:

pythontrain.py

注意:训练过程仅是为了演示流程,接下来模型预测和模型转换的都是yolov11默认的80类的模型。

2.5 PC端预测模型预测

训练完毕后,在default.yaml文件配置的project目录下保存训练过程,经验证集测试的最好结果的模型。同时可以执行模型预测,初步评估模型的效果。打开predict.py脚本,配置好模型地址和待检测图片,如下代码段所示:

if__name__ =='__main__': random.seed(0) device_ ="cpu" imgsz = (640,640) model_path ="./demo/weights/yolo11s.pt" img_path ="./demo/images/bus.jpg" is_dir = os.path.isdir(img_path) device = select_device(device_) model = YOLO(model_path) # 图片预处理 ifis_dir: filenames = os.listdir(img_path) foridx, fileinenumerate(filenames): img_file = os.path.join(img_path, file) im = cv2.imread(img_file) # uint8 numpy array pre_img, ratio, padding = preprocess(im, device, imgsz) # 模型预测 # pred = model.predict(pre_img, augment=False)[0] # im = draw_result(im, pred, ratio, padding) pred = model.predict(im, augment=False)[0] im = draw_result(im, pred) cv2.imshow("dst", im) cv2.waitKey() else: im = cv2.imread(img_path) # uint8 numpy array pre_img, ratio, padding = preprocess(im, device, imgsz) # 模型预测 # pred = model.predict(pre_img, augment=False)[0] # im = draw_result(im, pred, ratio, padding) pred = model.predict(im, augment=False)[0] im = draw_result(im, pred) cv2.imshow("dst", im) cv2.waitKey()

执行脚本:

pythonpredict.py

运行脚本结果:

2.6 PT模型转ONNX

在PC端执行export.py将pt模型转成onnx,如下代码段所示:

from ultralytics import YOLO

if__name__ =='__main__': format ='rknn'#'torchscript','onnx','openvino','engine','coreml','saved_model','pb','tflite','edgetpu','tfjs','paddle','ncnn' weight ="./demo/weights/yolo11s.pt" # pt 或 yolovx.yaml model = YOLO(weight) results = model.export(format = format)

3. rknn-toolkit模型转换

3.1 rknn-toolkit模型转换环境搭建

onnx模型需要转换为rknn模型才能在EASY-EAI-Orin-nano运行,所以需要先搭建rknn-toolkit模型转换工具的环境。当然tensorflow、tensroflow lite、caffe、darknet等也是通过类似的方法进行模型转换,只是本教程onnx为例。

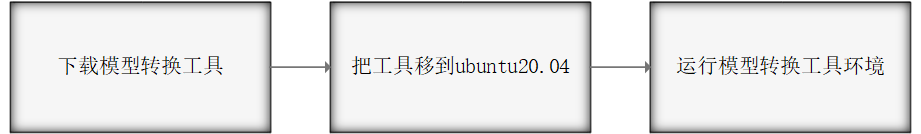

3.1.1 概述

模型转换环境搭建流程如下所示:

3.1.2 下载模型转换工具

为了保证模型转换工具顺利运行,请下载网盘里“06.AI算法开发/01.rknn-toolkit2模型转换工具/rknn-toolkit2-v2.3.0/docker/rknn-toolkit2-v2.3.0-cp38-docker.tar.gz”。

网盘下载链接:

https://pan.baidu.com/s/1J86chdq1klKFnpCO1RCcEA?pwd=1234

提取码:1234

3.1.3 把工具移到ubuntu20.04

把下载完成的docker镜像移到我司的虚拟机ubuntu20.04的rknn-toolkit2目录,如下图所示:

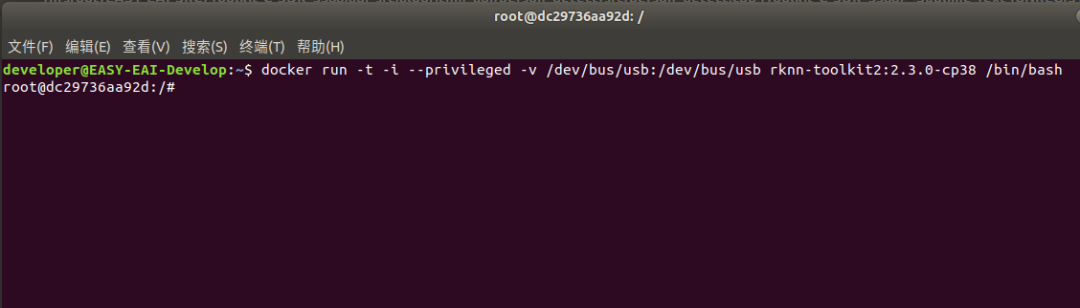

3.1.4 运行模型转换工具环境

在该目录打开终端:

执行以下指令加载模型转换工具docker镜像:

dockerload --input rknn-toolkit2-v2.3.0-cp38-docker.tar.gz

执行以下指令进入镜像bash环境:

docker run-t-i--privileged-v/dev/bus/usb:/dev/bus/usb rknn-toolkit2:2.3.0-cp38/bin/bash

现象如下图所示:

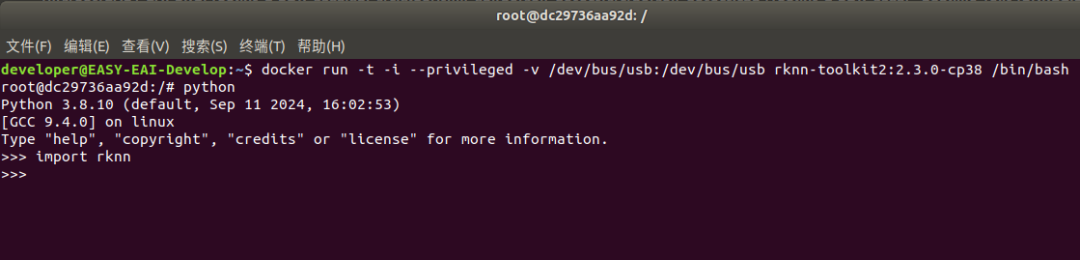

输入“python”加载python相关库,尝试加载rknn库,如下图环境测试成功:

至此,模型转换工具环境搭建完成。

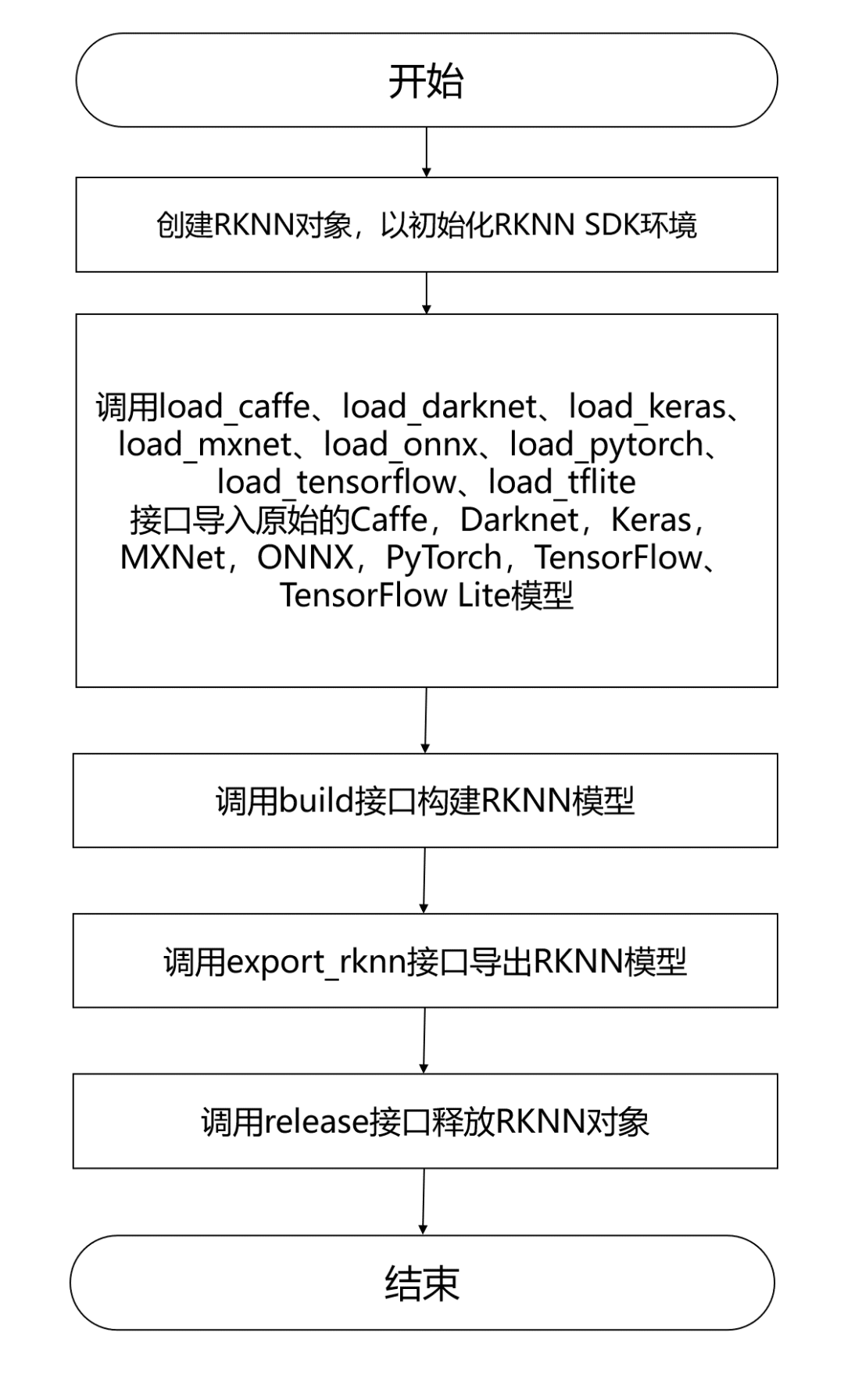

4. 模型转换为RKNN

EASY EAI Orin-nano支持.rknn后缀的模型的评估及运行,对于常见的tensorflow、tensroflow lite、caffe、darknet、onnx和Pytorch模型都可以通过我们提供的 toolkit 工具将其转换至 rknn 模型,而对于其他框架训练出来的模型,也可以先将其转至 onnx 模型再转换为 rknn 模型。模型转换操作流程如下图所示:

4.1 模型转换Demo下载

下载百度网盘链接:

https://pan.baidu.com/s/1IiOeH15nYrNu8k1LkyFoVQ?pwd=1234

提取码:1234。

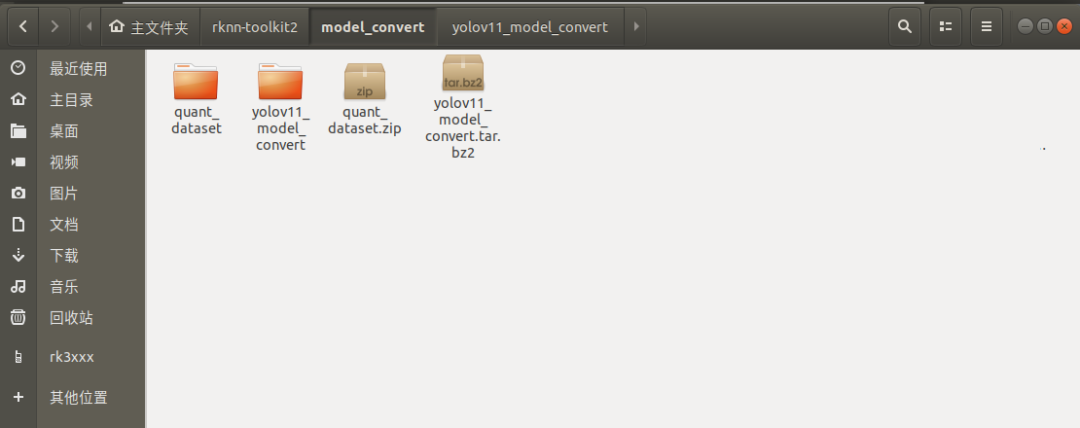

把 yolov11_model_convert.tar.bz2和quant_dataset.zip解压到虚拟机,如下图所示:

4.2 进入模型转换工具docker环境

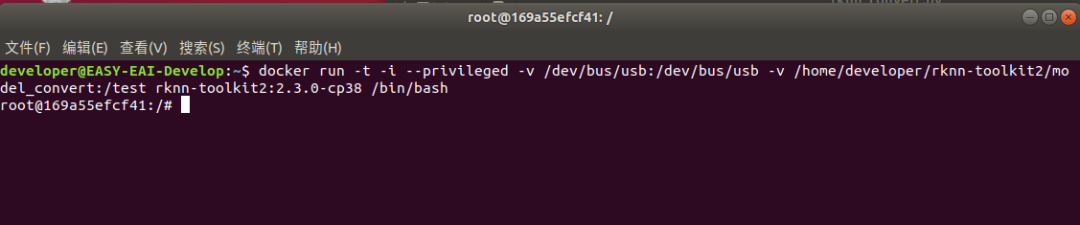

执行以下指令把工作区域映射进docker镜像,其中/home/developer/rknn-toolkit2/model_convert为工作区域,/test为映射到docker镜像,/dev/bus/usb:/dev/bus/usb为映射usb到docker镜像:

docker run -t -i --privileged -v /dev/bus/usb:/dev/bus/usb -v /home/developer/rknn-toolkit2/model_convert:/testrknn-toolkit2:2.3.0-cp38 /bin/bash

执行成功如下图所示:

4.3 模型转换操作说明

4.3.1 模型转换Demo目录结构

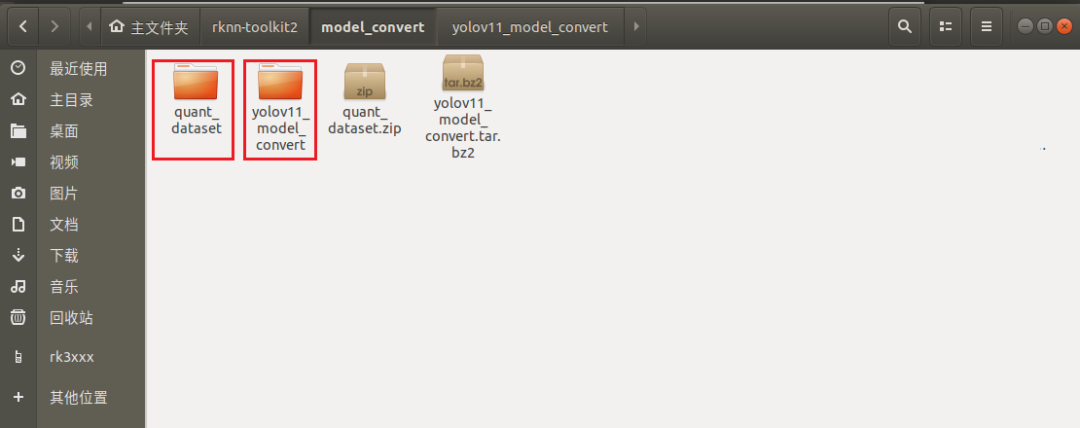

模型转换测试Demo由yolov11_model_convert和quant_dataset组成。yolov11_model_convert存放软件脚本,quant_dataset存放量化模型所需的数据。如下图所示:

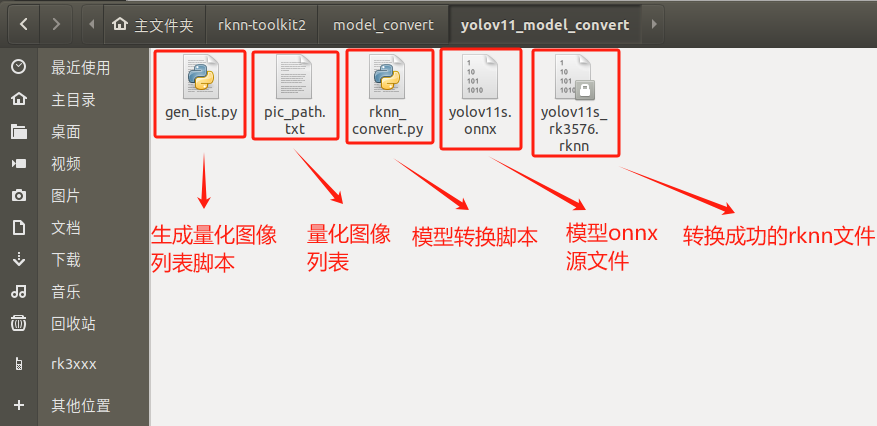

Yolov11_model_convert文件夹存放以下内容,如下图所示:

4.3.2 生成量化图片列表

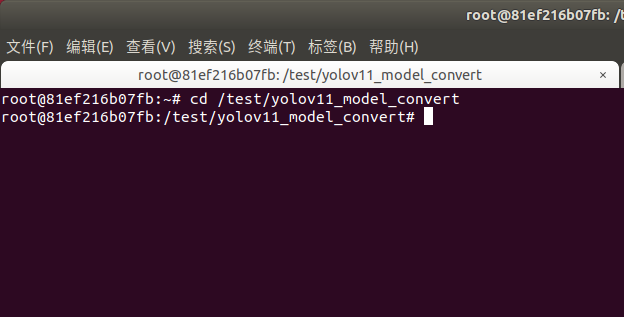

在docker环境切换到模型转换工作目录:

cd/test/yolov11_model_convert

如下图所示:

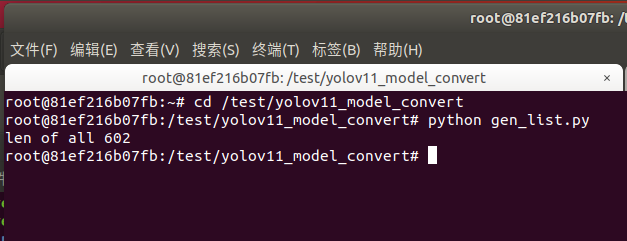

执行gen_list.py生成量化图片列表:

pythongen_list.py

命令行现象如下图所示:

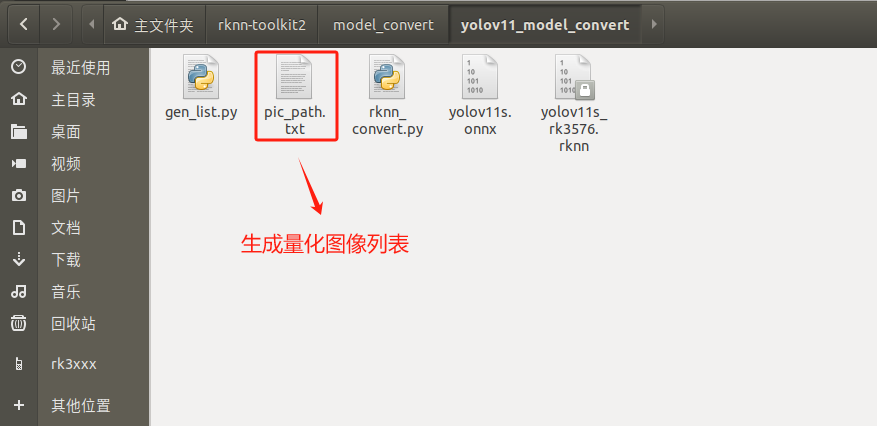

生成“量化图片列表”如下文件夹所示:

4.3.3 onnx模型转换为rknn模型

rknn_convert.py脚本默认进行int8量化操作,脚本代码清单如下所示:

importsysfromrknn.apiimportRKNN

ONNX_MODEL ='yolov11s.onnx'DATASET ='./pic_path.txt'RKNN_MODEL ='./yolov11s_rk3576.rknn'QUANTIZE_ON =True

if__name__ =='__main__':

# Create RKNN object rknn = RKNN(verbose=False)

# Pre-process config print('--> Config model') rknn.config(mean_values=[[0,0,0]], std_values=[ [255,255,255]], target_platform='rk3576') print('done')

# Load model print('--> Loading model') ret = rknn.load_onnx(model=ONNX_MODEL) ifret !=0: print('Load model failed!') exit(ret) print('done')

# Build model print('--> Building model') ret = rknn.build(do_quantization=QUANTIZE_ON, dataset=DATASET) ifret !=0: print('Build model failed!') exit(ret) print('done')

# Export rknn model print('--> Export rknn model') ret = rknn.export_rknn(RKNN_MODEL) ifret !=0: print('Export rknn model failed!') exit(ret) print('done')

# Release rknn.release()

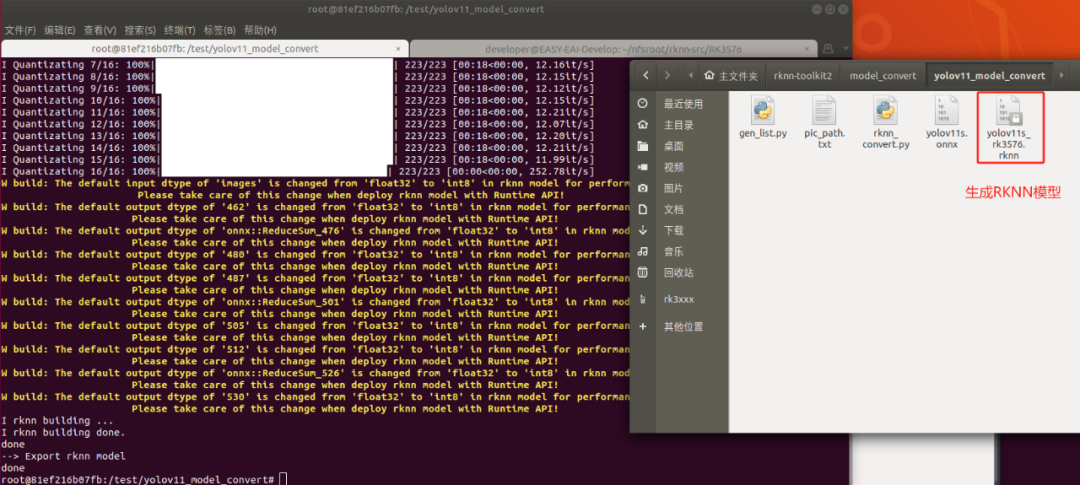

把onnx模型yolov11s.onnx放到yolov11_model_convert目录(后续用户使用自己的模型的时候,替换掉对应的onnx即可),并执行rknn_convert.py脚本进行模型转换:

pythonrknn_convert.py

生成模型如下图所示,此模型可以在rknn环境和EASY EAI Orin-nano环境运行:

5. 模型部署示例

5.1 模型部署示例介绍

本小节展示yolo11模型的在EASY EAI Orin-nano的部署过程,本章章节使用的yolo11s.rknn模型的是由Ultralytics 官方提供的yolo11s.pt转换而来。

5.2 源码下载以及例程编译

下载yolo11 C Demo示例文件。

百度网盘链接:

https://pan.baidu.com/s/1B5GSc48RjQmZijUDLhB1iA?pwd=1234

提取码: 1234。

下载程序包移至ubuntu环境后,执行以下指令解压:

tar-xvf yolov11_detect_C_demo.tar.bz2

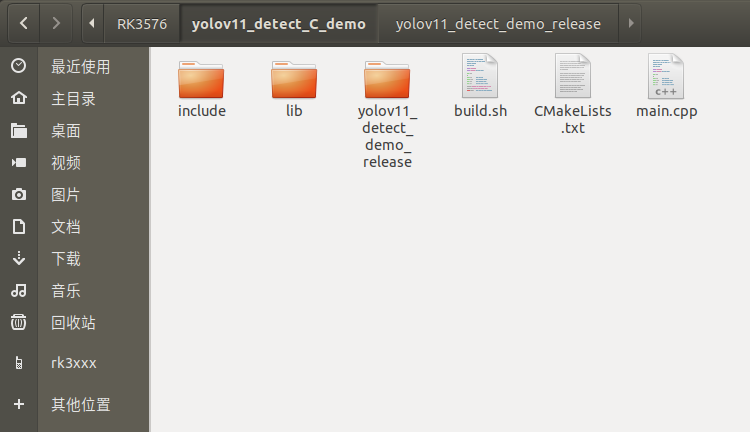

下载解压后如下图所示:

通过adb接口连接EASY-EAI-Orin-nano,

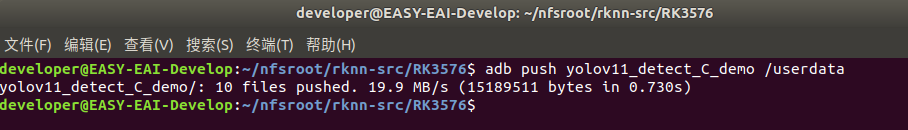

接下来需要通过adb把源码传输到板卡上,先切换目录然后执行以下指令:

cd~/rknn-toolkit2adb push yolov11_detect_C_demo/ /userdata

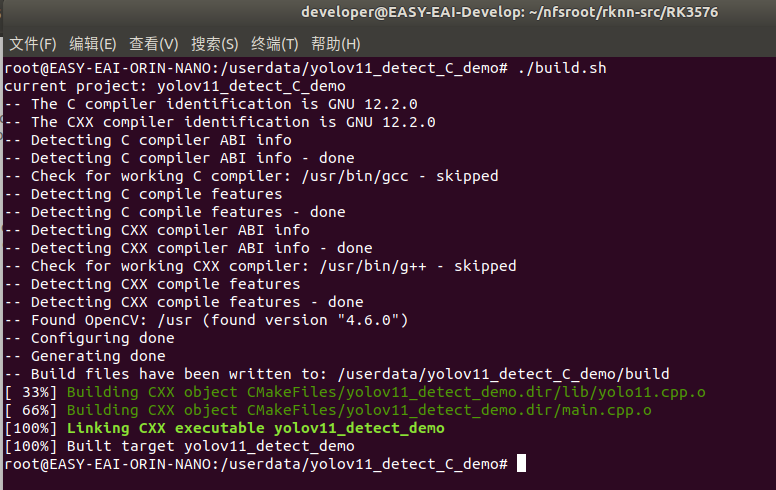

登录到板子切换到例程目录执行编译操作:

adb shellcd/userdata/yolov11_detect_C_demochmod777 build.sh./build.sh

5.3 开发板执行yolov11目标检测算法

编译成功后切换到可执行程序目录,如下所示:

cd/userdata/yolov11_detect_C_demo/yolov11_detect_demo_release

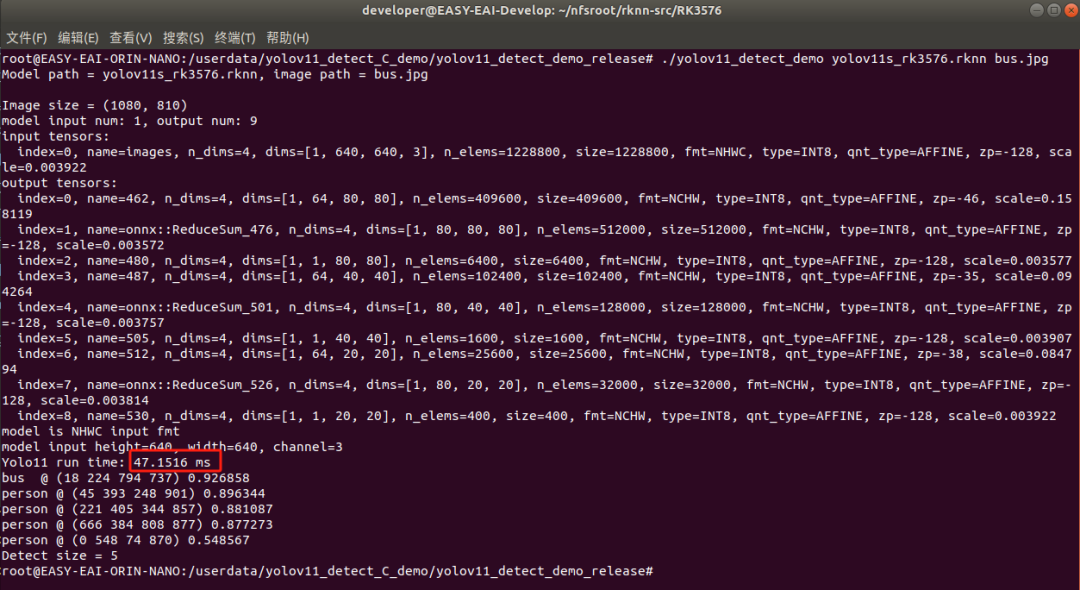

运行例程命令如下所示:

chmod777 yolov11_detect_demo./yolov11_detect_demo yolov11s_rk3576.rknn bus.jpg

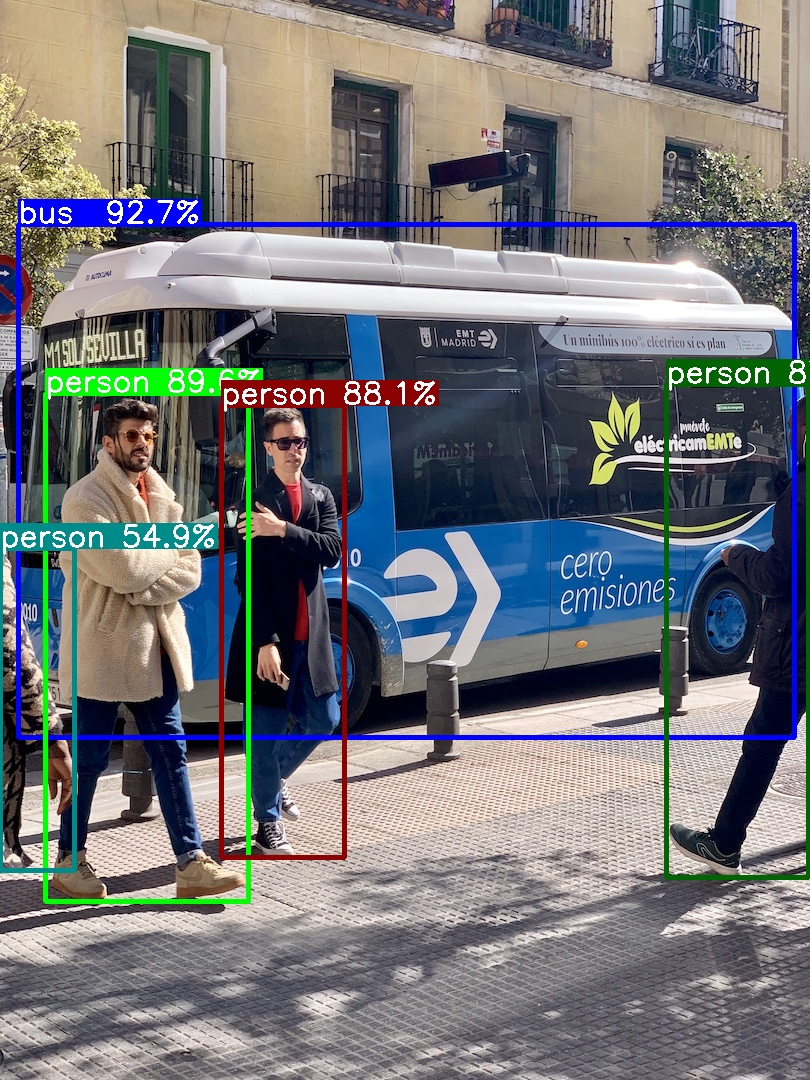

执行结果如下图所示,yolov11s算法执行时间为47ms:

退出板卡环境,取回测试图片:

exitadb pull /userdata/yolov11_detect_C_demo/yolov11_detect_demo_release/results.jpg .

测试结果如下图所示:

至此,yolov11目标检测例程已成功在板卡运行。